Введение

Современные операционные системы Windows 7, Windows Server 2008 и всё, что старше, умеют подключаться напрямую на iSCSI target. Проблема только в том, как инициализировать удаленное блочное устройство при включении ПК.

Вспомним, что почти все современные сетевые карты умеют загружаться по технологии PXE. А вот с iSCSI дружат в основном только дорогостоящие серверные сетевые карты, например Intel. Однако, существует как минимум два open source проекта gPXE и iPXE позволяющий при загрузке ПК подключаться iSCSI устройствам. Последний, к слову, форк первого, с немного доработанной системой вывода ошибок и дополнительными опциями.

Есть много способов, как загружаться через gPXE и iPXE. В данном посте мы будем рассматривать загрузку с использованием iPXE и подключением для него необходимых скриптов в процессе загрузки.

Суть такова — при запуске компьютера PXE загрузчик получает необходимые настройки через DHCP и загружает PXELINUX, который задает необходимые параметры и загружает iPXE, который, в свою очередь, выступает iSCSI инициатором и передает управление диску. До момента инициализации блочного устройства передачу файлов по сети обеспечивает протокол TFTP.

Для чего мы загружаем PXELINUX?

Очереди виртуальных машин (ВМКС)

ВМКС — это функция сетевого интерфейса, которая выделяет очередь для каждой виртуальной машины. Когда Hyper-V включен; также необходимо включить VMQ. в Windows Server 2016 вмкс использовать NIC Switch впортс с одной очередью, назначенной впорт, для предоставления тех же функций.

В зависимости от режима конфигурации коммутатора и алгоритма распределения нагрузки объединение сетевых карт представляет собой минимальное количество доступных и поддерживаемых очередей любым адаптером в группе (режим min-Queues) или общее число очередей, доступных для всех участников группы (режим SUM-of-Queues).

Если команда находится в режиме объединения Switch-Independent и вы устанавливаете распределение нагрузки в режим порта Hyper-V или динамический режим, число сообщаемых очередей — это сумма всех очередей, доступных для членов группы (режим SUM-of-Queues). В противном случае количество очередей в отчете является наименьшим числом очередей, поддерживаемых любым участником команды (режим min-Queues).

Далее описывается, почему это происходит:

-

Если независимая команда находится в режиме порта Hyper-V или в динамическом режиме, входящий трафик для порта коммутатора Hyper-V (ВМ) всегда поступает на один и тот же участник команды. Узел может предсказать или контролировать, какой член получает трафик для конкретной виртуальной машины, чтобы объединение сетевых карт было более продуманным, чем очереди VMQ, выделяемые для конкретного участника команды. Объединение сетевых карт, работа с коммутатором Hyper-V, устанавливает VMQ для виртуальной машины на точно одном члене команды и определяет, что входящий трафик поступает в эту очередь.

-

Если команда находится в любом режиме, зависимом от переключения (статическое объединение или объединение LACP), коммутатор, к которому подключена команда, управляет распределением входящего трафика. Программному обеспечению для объединения сетевых карт не удается предсказать, какой член команды получает входящий трафик для виртуальной машины. возможно, коммутатор распределяет трафик для виртуальной машины по всем членам группы. В результате работы программы объединения сетевых карт, работающей с коммутатором Hyper-V, программа программирует очередь для виртуальной машины на всех участниках группы, а не только на одном члене команды.

-

Если команда находится в режиме, независимом от переключения, и использует балансировку нагрузки хэша адреса, входящий трафик всегда поступает на один сетевой адаптер (основной член группы) — все это только один участник команды. Поскольку другие члены команды не работают с входящим трафиком, они запрограммированы с помощью тех же очередей, что и основной участник, поэтому при сбое основного участника любой другой член команды может использоваться для получения входящего трафика, и очереди уже существуют.

-

Большинство сетевых адаптеров используют очереди для масштабирования на стороне приема (RSS) или VMQ, но не в одно и то же время. Некоторые параметры VMQ выглядят как параметры для очередей RSS, но являются параметрами универсальных очередей, которые используются как для RSS, так и для VMQ в зависимости от того, какая функция используется в настоящее время. Каждая сетевая карта имеет в своих дополнительных свойствах значения * Рссбасепрокнумбер и * Максрсспроцессорс. Ниже приведены несколько параметров VMQ, обеспечивающих лучшую производительность системы.

-

В идеале для каждой сетевой карты необходимо, чтобы для параметра * Рссбасепрокнумбер было установлено четное число, большее или равное двум (2). Первый физический процессор, ядро 0 (логические процессоры 0 и 1) обычно выполняет большую часть системной обработки, поэтому сетевая обработка должна отойти от этого физического процессора. Некоторые архитектуры компьютеров не имеют двух логических процессоров на один физический процессор, поэтому для таких компьютеров базовый процессор должен быть больше или равен 1. Если вы сомневаетесь в том, что ваш узел использует 2 логических процессора на архитектуру физического процессора.

-

Если команда находится в режиме суммирования очередей, процессоры членов группы должны быть не перекрывающиеся. Например, в 4-ядерном хосте (8 логических процессорах) с группой из 2 10 Гбит/сетевых интерфейсов можно установить первый из них, чтобы использовать базовый процессор 2 и использовать 4 ядра; второй будет установлен для использования базового процессора 6 и 2 ядер.

-

Если команда работает в Min-Queues режиме, наборы процессоров, используемые членами команды, должны быть идентичны.

Introduction

LACP and MPIO technologies seem to play the same role:

- Providing fault-tolerance.

- Increasing performance for particular operations where it’s otherwise not enough.

The methods are different. LACP bundles physical ports together into a bigger channel, basically turning a few small “pipes” into one big “pipe”. MPIO provides up to 32 alternate data paths, achieving pretty much the same effect. As a result, there’s gain in redundancy and performance. This test is going to show which technology is more convenient and effective to use in Windows environment in the specific of using iSCSI target and initiator, used by Microsoft.

Подключение рабочих станций

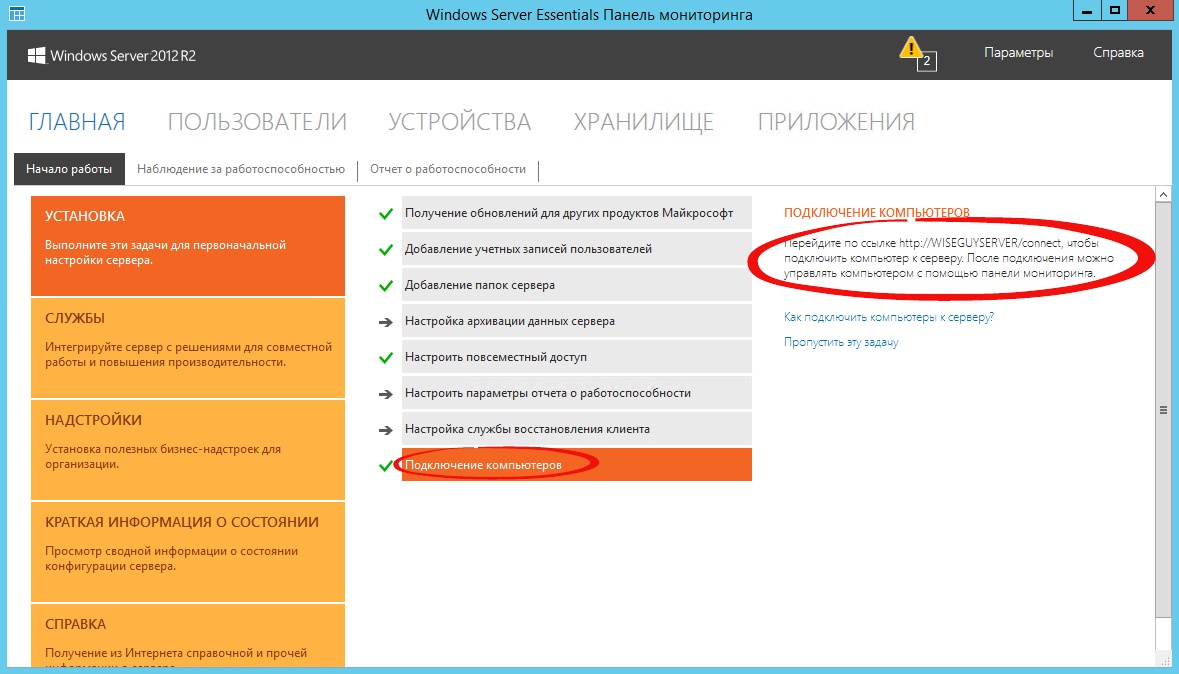

Откроем панель мониторинга и перейдем на страницу подключение компьютеров, то увидим там лишь инструкцию к действию.

Рис.28 Инструкция к действию

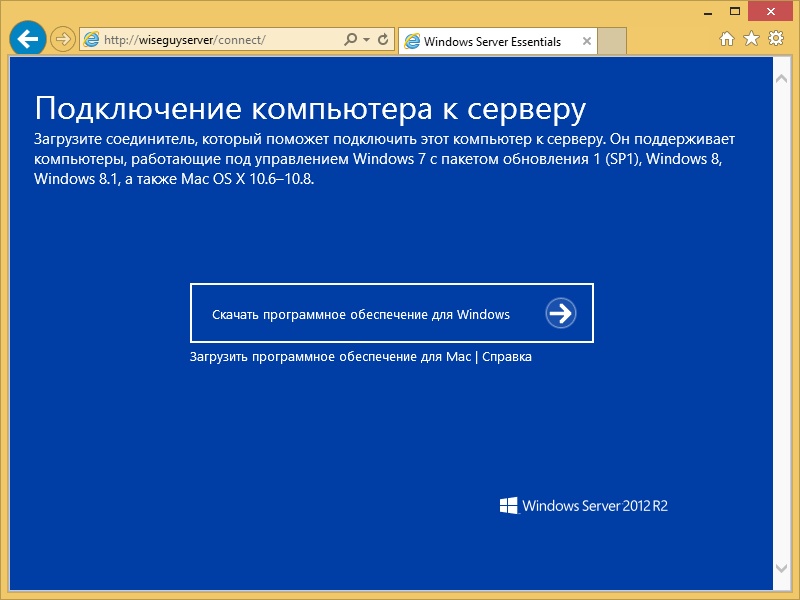

Следуя инструкции на клиенте в браузере открываем страничку http://<Имя сервера>/connect. Нажимаем ссылку для скачивания.

Рис.29 Подключение ПК к серверу

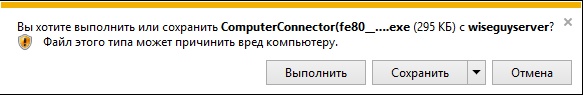

Выбираем выполнить.

Рис.30 Выбираем выполнить

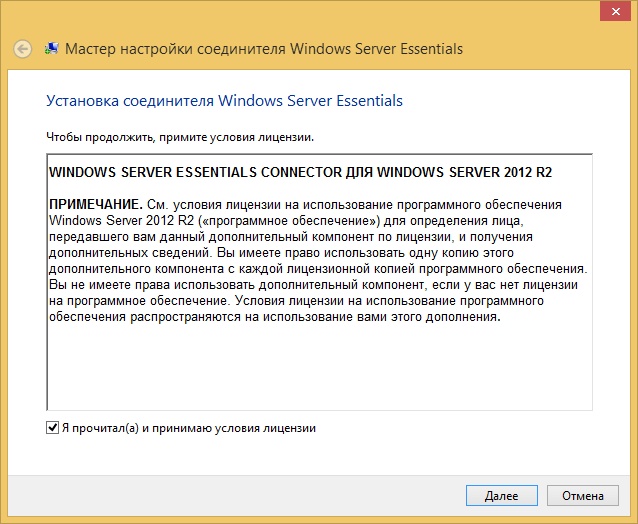

Принимаем лицензию и ждем

Рис. 31 Лицензионное соглашение

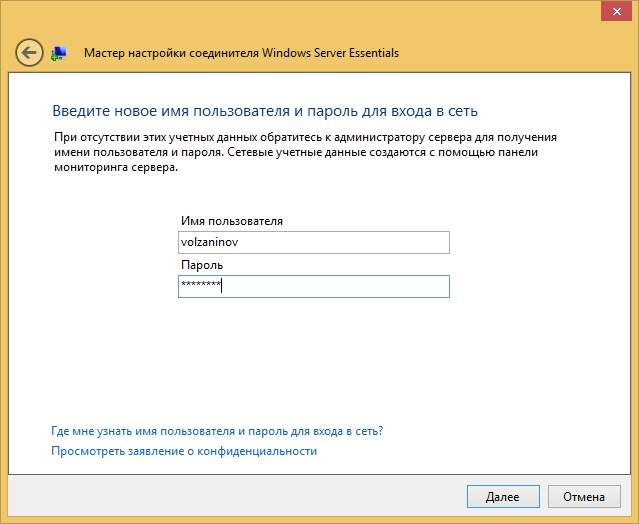

Вводим имя пользователя и пароль пользователя данного компьютера или администратора.

Рис.32 Окно ввода учетных данных

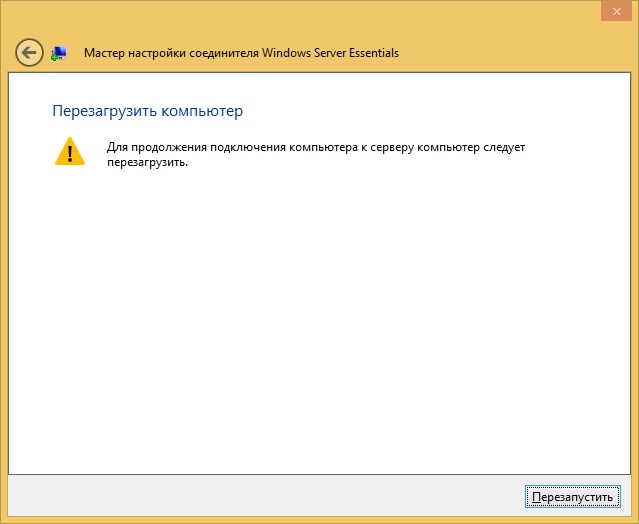

Перезагружаем сервер.

Рис. 33 Перезагрузка сервера

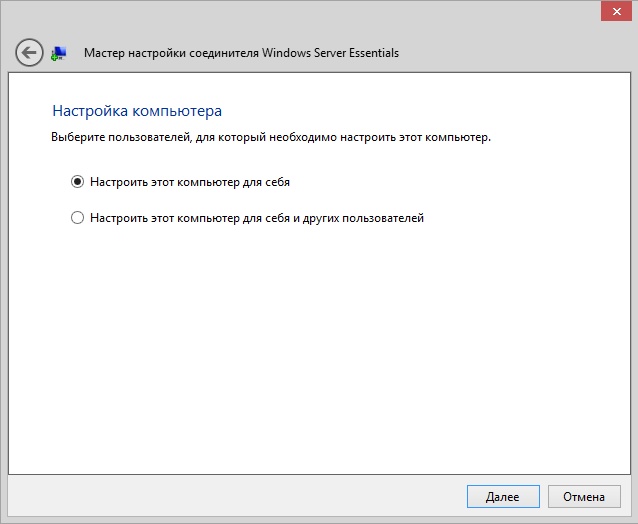

Выбираем, кто будет пользоваться компьютером.

Рис. 34 Выбор пользователя для настройки ПК

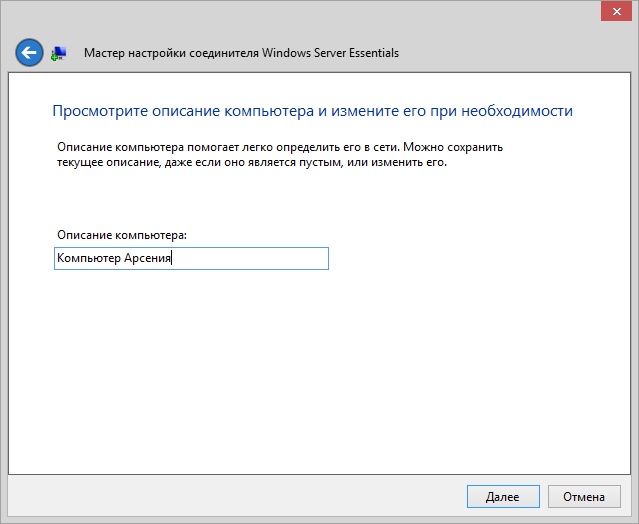

Вводим описание компьютера.

Рис. 35 Описание ПК

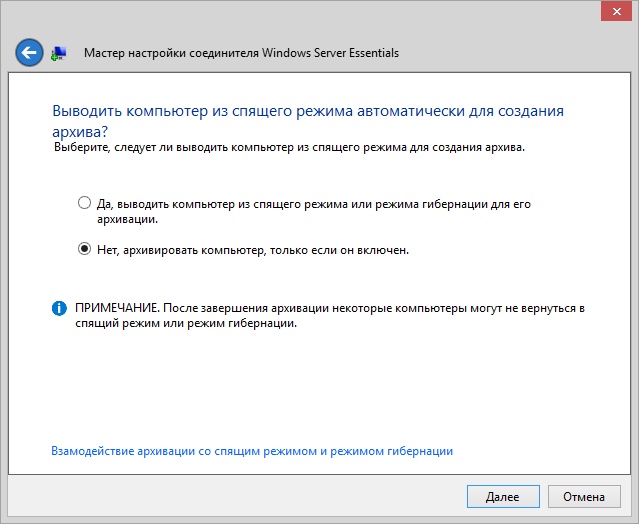

Параметры архивации.

Рис. 36 Параметры архивации

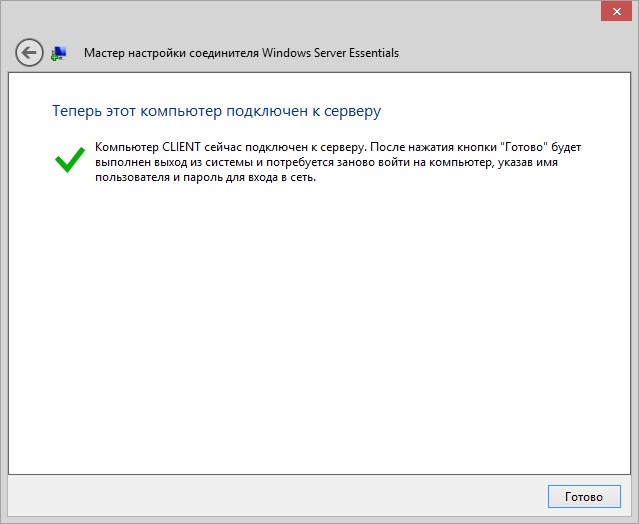

Рис. 37 ПК подключен к серверу

После этого заходим на компьютер под учетной записью пользователя.

Предшествующие версии Windows

Windows 8.1

| Версия операционной системы | Ключ установки клиента KMS |

|---|---|

| Windows 8.1 Профессиональная | GCRJD-8NW9H-F2CDX-CCM8D-9D6T9 |

| Windows 8.1 Pro N | HMCNV-VVBFX-7HMBH-CTY9B-B4FXY |

| Windows 8.1 Корпоративная | MHF9N-XY6XB-WVXMC-BTDCT-MKKG7 |

| Windows 8.1 Корпоративная N | TT4HM-HN7YT-62K67-RGRQJ-JFFXW |

Windows 8

| Версия операционной системы | Ключ установки клиента KMS |

|---|---|

| Windows 8 Профессиональная | NG4HW-VH26C-733KW-K6F98-J8CK4 |

| Windows 8 Pro N | XCVCF-2NXM9-723PB-MHCB7-2RYQQ |

| Windows 8 Корпоративная | 32JNW-9KQ84-P47T8-D8GGY-CWCK7 |

| Windows 8 Корпоративная N | JMNMF-RHW7P-DMY6X-RF3DR-X2BQT |

Windows 7

| Версия операционной системы | Ключ установки клиента KMS |

|---|---|

| Windows 7 Профессиональная | FJ82H-XT6CR-J8D7P-XQJJ2-GPDD4 |

| Windows 7 Профессиональная N | MRPKT-YTG23-K7D7T-X2JMM-QY7MG |

| Windows 7 Профессиональная E | W82YF-2Q76Y-63HXB-FGJG9-GF7QX |

| Windows 7 Корпоративная | 33PXH-7Y6KF-2VJC9-XBBR8-HVTHH |

| Windows 7 Корпоративная N | YDRBP-3D83W-TY26F-D46B2-XCKRJ |

| Windows 7 Корпоративная E | C29WB-22CC8-VJ326-GHFJW-H9DH4 |

Подключение диска iSCSI

1. Зайдите в «Панель Управления -> Администрирование » и запустите Инициатор iSCSI .

2. В разделе «Свойства Обнаружение » и нажмите кнопку «Обнаружить портал ».

3. В открывшемся окне заполните поле «IP адрес» сервера iSCSI.

4. Откройте раздел дополнительных параметров подключения к серверу (нажмите кнопку «Дополнительно »). Выберите значения полей «Локальный адаптер » и «IP-адрес инициатора », как на рисунке ниже (где IP-адрес инициатора — это IP вашего локального сетевого адаптера, через который разрешено подключение к серверу iSCSI).

5. Сохраните настройки, убедитесь в получении изображения, подобного приведенному ниже:

6. В разделе «Свойства » инициатора iSCSI перейдите на вкладку «Конечные объекты », выберите появившийся объект с неактивным состоянием и нажмите кнопку «Подключить ».

7. В открывшемся окне «Подключение к конечному объекту », нажмите кнопку «Дополнительно… »

8. Заполните поля раздела, как на рисунке ниже. Параметры «Имя» и «Секрет» — это «Логин» и «Пароль» из письма, отправленного вам при активации услуги.

9. Сохраните настройки. Убедитесь, что значение поля «Состояние » обнаруженного конечного объекта – «Подключено », как на рисунке ниже. Выйдите из раздела «Свойства » Инициатора iSCSI, сохранив настройки.

Перед началом работы

ознакомьтесь с дисковые пространства прямыми требованиями к оборудованию и считывает этот документ, чтобы ознакомиться с общим подходом и важными примечаниями, связанными с некоторыми шагами.

Соберите следующие сведения:

Вариант развертывания. дисковые пространства Direct поддерживает с объединением, также известное как агрегированное. Ознакомьтесь с преимуществами каждого из них, чтобы решить, что вам подходит. Шаги 1-3 ниже применимы к обоим вариантам развертывания. Шаг 4 необходим только для согласованного развертывания.

Имена серверов. Ознакомьтесь с политиками именования в Организации для компьютеров, файлов, путей и других ресурсов. Необходимо подготавливать несколько серверов, каждый из которых имеет уникальные имена.

Доменное имя. Ознакомьтесь с политиками организации по именованию доменов и присоединению к домену. Вы присоедините серверы к домену, и вам потребуется указать имя домена.

Сеть RDMA. Существует два типа протоколов RDMA: iWarp и Роце

Обратите внимание, какой из них использует сетевые адаптеры, и если Роце, также обратите внимание на версию (v1 или v2). Для Роце также обратите внимание на модель коммутатора верхнего уровня

ИД ВИРТУАЛЬНОЙ ЛС

Запишите идентификатор виртуальной ЛС, который будет использоваться для сетевых адаптеров ОС управления на серверах, если таковые имеются. Его можно получить у администратора сети.

Дополнительно

Как активировать Windows Server 2012 R2? Ниже строки с установками часового пояса в меню диспетчера серверов есть пункт «Код продукта». Чтобы ввести его, выберите этот пункт и в окне введите ключ продукта, нажмите «Активировать».

И ещё, некоторых пользователей интересует вопрос — как удалить службу в Windows Server 2008 R2? Для этого выполните следующее:

- Откройте Панель управления, меню Система и безопасность.

- Выберите раздел Администрирование, где будет пункт Службы.

- Перед вами появится список служб — выберите ту, что вас интересует, нажмите на её свойства и в появившемся окне кликните на «Остановить».

Другой способ — откройте командную строку и введите комбинацию sc delete, сразу за ней — название службы, нажмите Enter.

На этом всё — теперь вы знаете, как установить Server 2008 R2 и 2012, настроить каждую из этих версий для первоначального пользования. Можем сделать вывод, что все вышеприведённые операции выполнить нетрудно, главное — хорошо разобраться в них и следовать инструкциям, быть внимательным к мелочам.

Добавление маршрутов

С инфраструктурой закончили. Роутеры готовы обмениваться таблицами. Но мы пока не указали маршруты, поэтому отсылать нечего. За маршруты отвечает командлет Add-BgpCustomRoute. Самый простой способ — это просто указать сеть (-Network) или интерфейс (-Interface).

Во втором случае в анонс BGP теоретически должны автоматически подхватываться и все статические маршруты, привязанные к интерфейсу, но это происходит почему-то не всегда. Имя адаптера можно узнать при помощи Get-NetAdapter.

Можно комбинировать оба параметра (Network и Interface), добавляя в анонс сети, с которыми нет непосредственного подключения или которые не указаны в static route.

Протокол BGP поддерживает возможности суммирования (aggregate) маршрутов — очень гибкая функция, позволяющая оптимизировать таблицу благодаря тому, что несколько сетей передаются как один маршрут. В Win 2012 R2 поддержка aggregate реализована еще не была, а в Win 2016 уже появились командлеты Add/Set-BgpRouteAggregate, позволяющие добавлять и изменять aggregate-маршрут. Соберем все сети в один маршрут.

После добавления маршрутов начнется обмен таблицами, результат можем просмотреть при помощи Get-BgpRouteInformation, статистику — Get-BgpStatistics. Но даже в небольших сетях можно увидеть, что мы получаем от пиров много мусора, а сами отправляем им лишнюю информацию. Для решения этих вопросов используются политики.

Добавляем маршруты

Установка Hyper-V Server 2012 R2

Первым делом скачиваем свежую версию гипервизора с сайта Microsoft. Скачивать нужно обязательно английскую версию. Во-первых, в русской были некоторые баги, хотя их могли и пофиксить уже, но дело не только в этом. Для автоматизации и упрощения настройки Hyper-V Server 2012 R2 мы будем использовать скрипты, написанные для английской версии, в русской они работать не будут. Я сначала поставил русскую версию, потратил какое-то время, потом плюнул и переустановил систему.

Установка достаточно банальна и ничем принципиально не отличается от любой другой установки windows. Скачивается образ, с него загружается система и устанавливается. В конце установки нас встречает консоль с настройками Hyper-V Server 2012 R2:

Сразу же дам подсказку на случай, если вы Hyper-V Server Configuration console закроете. Запустить снова ее можно командой sconfig. Мне пришлось потратить прилично времени, чтобы найти как это сделать без перезагрузки сервера.

Установка серверной версии Windows

Отметим, что существует несколько версий этого обеспечения — 2003, 2008 и 2012 года. Исходя из того, что последние версии всегда в большем приоритете, мы рассмотрим, как происходит установка Windows Server 2012. Даже если вас интересует, как установить Windows Server 2008 R2, не переживайте — оба процесса практически совпадают, поэтому вы легко сориентируетесь по нижеизложенной инструкции.

Итак, установка Windows Server 2012 R2 делается следующим образом:

- Зайдите в BIOS компьютера и установите загрузку с CD-ROM.

- Вставьте диск с образом системы, запустите свой ПК, чтобы он начал загрузку с внешнего носителя.

- После загрузки появится окно, где нужно указать язык, раскладку клавиатуры, и часовой пояс — сделайте это, следуйте далее.

- Нажмите «Установить».

- Перед вами появится запрос на выбор системы — есть несколько версий серверного обеспечения. Выберите необходимую версию, жмите «Далее».

- Примите условия лицензии.

- Выберите тип установки — если вы ставите Server с нуля, следует выбирать только вариант «Выборочная».

- Укажите накопитель, куда будет поставлена система, при необходимости разбейте диск на несколько разделов. При делении вам нужно согласиться на создание разделов для системных файлов.

- Кстати, обычно выбирается раздел «Основной» жёсткого диска.

- Нажимаем «Далее», и ждём, пока обеспечение загрузится на ПК.

- После перезагрузки вам предстоит создать пароль для входа в учётную запись — выбирайте надёжную и сложную комбинацию, при желании измените имя пользователя.

- Далее, перед вами появится стартовое окно системы, где будет написано, что нужно нажать Ctrl+Alt+Del — сделайте это, и введите созданный только что пароль.

- На этом установка Windows Server завершена — как видите, в процессе нет ничего сложного, почти все действия выполняются автоматически под вашим руководством.

Windows 10, все поддерживаемые версии Semi-Annual Channel

См. в разделе Справочные материалы по жизненному циклу Windows сведения о поддерживаемых версиях и конечных датах обслуживания.

| Версия операционной системы | Ключ установки клиента KMS |

|---|---|

| Windows 10 Pro | W269N-WFGWX-YVC9B-4J6C9-T83GX |

| Windows 10 Pro N | MH37W-N47XK-V7XM9-C7227-GCQG9 |

| Windows 10 Pro для рабочих станций | NRG8B-VKK3Q-CXVCJ-9G2XF-6Q84J |

| Windows 10 Pro для рабочих станций N | 9FNHH-K3HBT-3W4TD-6383H-6XYWF |

| Windows 10 Pro для образовательных учреждений | 6TP4R-GNPTD-KYYHQ-7B7DP-J447Y |

| Windows 10 Pro для образовательных учреждений N | YVWGF-BXNMC-HTQYQ-CPQ99-66QFC |

| Windows 10 для образовательных учреждений | NW6C2-QMPVW-D7KKK-3GKT6-VCFB2 |

| Windows 10 для образовательных учреждений N | 2WH4N-8QGBV-H22JP-CT43Q-MDWWJ |

| Windows 10 Корпоративная | NPPR9-FWDCX-D2C8J-H872K-2YT43 |

| Windows 10 Корпоративная N | DPH2V-TTNVB-4X9Q3-TJR4H-KHJW4 |

| Windows 10 Корпоративная G | YYVX9-NTFWV-6MDM3-9PT4T-4M68B |

| Windows 10 Корпоративная G N | 44RPN-FTY23-9VTTB-MP9BX-T84FV |

Подключение к Hyper-V Server 2016 с Windows 7

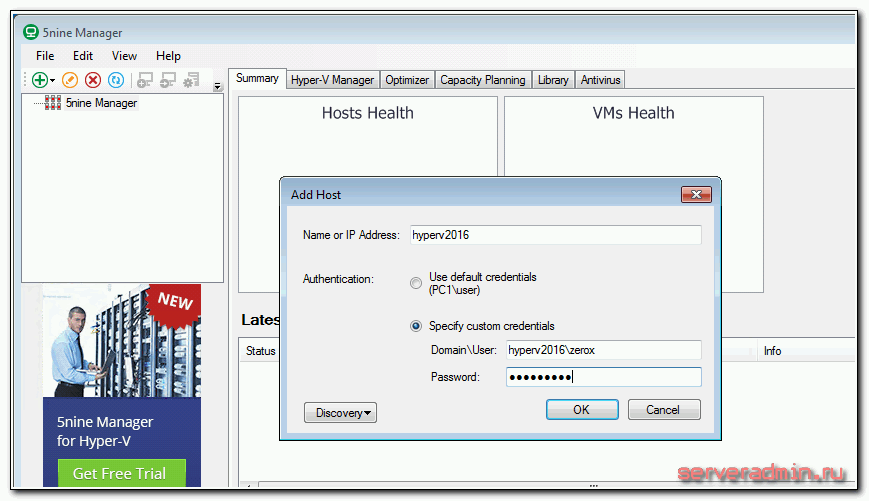

Рассмотрим еще один вариант подключения к бесплатному hyper-v, когда у вас в наличие только операционная система Windows 7. Вам нужно создать виртуальную машину, либо изменить настройки существующей, завершить ее работу, или наоборот запустить. Оснастку управления Hyper-V на Windows 7 поставить не получится. На помощь придет программа 5nine Manager Free. Скачать ее можно либо с указанного сайта, но нужна регистрация, после которой на почту придет ссылка для скачивания и файл с лицензией. Для нормальной установки требуется .NET Framework 4.5 или выше. Если в системе он не будет установлен, то инсталлятор просто не начнет установку, даже не сказав почему. Мне пришлось читать руководство, чтобы разобраться, почему на один компьютер у меня нормально ставится программа, а на другой не хочет.

После установки запускайте программу и добавляйте hyperv server.

Там вы сможете управлять некоторыми настройками гипервизора, добавлять, удалять, запускать, редактировать виртуальные машины. Все сделано достаточно просто и удобно.

Если нет стандартной оснастки, эта программа выручает. Сам ей частенько пользуюсь при необходимости.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

Установка MPIO в Windows Server 2016/2012R2

Windows Server поддерживает многопутевой ввод-вывода MPIO начиная с версии Windows Server 2008 R2. Технология Microsoft MPIO позволяет обеспечить высокую доступность и балансировку нагрузки посредством возможности организации нескольких подключений к СХД, не зависит от протоколов и поддерживает подключение дисковых массивов и хранилищ по iSCSI, Fiber Channel и хранилищ SAS.

MPIO-модуль в Windows Server по умолчанию не включен. Установить его в Windows Server 2016 можно двумя способами:

- Из графического интерфейса с использованием консоли Server Manager

- Из командной строки Powershell

Установка MPIO с помощью Powershell

Запустите консоль PowerShell с правами администратора и для установки компонента выполните команду:

Add-WindowsFeature -Name ‘Multipath-IO’

Чтобы убедиться, что модуль MPIO установлен в вашем Windows Server, выполните:

Get-WindowsFeature -Name ‘Multipath-IO’

Remove-WindowsFeature -Name ‘Multipath-IO’

Добавление соединений iSCSI с помощью MPIO

Откройте окно свойств инициатора iSCSI на хосте Windows Server. Нажмите «Диспетчер серверов» > «Панель мониторинга» > «Инструменты» > «Инициатор iSCSI».В диалоговом окне «Свойства инициатора iSCSI» перейдите на вкладку «Обнаружение» и нажмите «Обнаружить целевой портал».

Далее введите свой первый IP-адрес iSCSI и нажмите кнопку «Дополнительно».

В разделе «Дополнительные настройки» вы можете указать конкретный локальный адаптер и IP-адрес инициатора.

р>

Проделайте это для нескольких целевых порталов. Как вы можете видеть ниже, у меня есть разные IP-адреса целевого портала, которые были добавлены с использованием определенного сетевого адаптера, соответствующего сетевому адресу/подсети целевого портала.

После добавления порталов перейдите на вкладку «Цели». Вы увидите обнаруженные цели, и они, скорее всего, будут в неактивном состоянии. Нажмите кнопку «Подключиться».

В диалоговом окне «Подключиться к цели» установите флажок «Включить несколько путей», а затем нажмите кнопку «Дополнительно».

Вот где настоящая магия подключений MPIO вступает в игру. Ниже я устанавливаю локальный адаптер, затем IP-адрес инициатора и IP-адрес целевого портала. Таким образом, наша конечная цель — настроить соединения с использованием каждого IP-адреса адаптера портала.

Нажмите кнопку «Подключиться» еще раз на той же обнаруженной цели. Теперь я использую второй IP-адрес инициатора и IP-адрес целевого портала для второго подключения к той же цели.

Теперь мы видим статус Connected. Нажмите кнопку «Свойства», чтобы проверить состояние MPIO.

Обратите внимание, что у вас есть два идентификатора. Нажмите на каждый из них, и вы увидите соответствующий тег группы целевых порталов

р>

Нажав на второй идентификатор, вы заметите, что тег группы целевого портала является вторым тегом группы.

р>

Перейдите на вкладку «Группы порталов», и вы увидите оба связанных сетевых портала.

Для каждого идентификатора можно настроить несколько подключенных сеансов, нажав кнопку MCS.

- Только отказоустойчивость

- Круговая система

- Круговой перебор с подмножеством

- Наименьшая длина очереди

- Взвешенные пути

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

- Необходимо выбрать тип пула: thick (место выделяется сразу) или thin (место выделяется по мере заполнения). Отметим, что thick пулы являются более производительными.

- Выбрать конкретные диски

- Уровень RAID

- Указать параметры физических накопителей, влияющие на их производительность.

Рекомендуется использовать установки по умолчанию для максимальной скорости:- Enable Disk Write Cache

- Enable Disk Read-ahead

- Enable Disk Command Queuing

- Disable Disk Standby

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии. С принципом работы таких пулов можно ознакомиться в отдельной статье.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. Рассмотрим их более подробно.

- Block Size – размер блока, который будет эмулироваться для хоста. Для Windows Server рекомендуется задать значение 4КБ как наиболее оптимальное.

- Background I/O Priority – приоритет фоновых задач (расширение, миграция и пр.)

- Erase Volume Data – необходимость зануления создаваемого тома. Значение Fast Erase соответствует записи нулей в первый гигабайт пространства, может быть полезно при повторном использовании дисков с целью удалить остатки предыдущих данных (стереть таблицы размещения). Full Erase – запись нулей по всему объему, полезно для достижения максимальной производительности в случае использования RAID 1/10.

- Enable Cache Mode (Write-back Cache) – включение кэша СХД. Очень сильно влияет на производительность.

- Enable Video Editing Mode – снижение производительности ради более стабильных результатов. Если не предполагается использование тома в системах видеонаблюдения, лучше выключить данный параметр.

- Enable Read-ahead – включение упреждающего чтения. Положительно влияет на производительность.

- Enable Fast RAID Rebuild – при активации данной настройки система будет вести трекинг всех записываемых блоков, чтобы понимать, сколько реальных данных записано на том. В случае выхода из строя диска в составе RAID группы во время ребилда не будут копироваться пустые блоки, что может ускорить данный процесс. Однако стоит помнить, что использование Fast Rebuild снижает производительность при случайном доступе.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

- Необходимо выбрать протокол доступа: FCP (Fibre Channel) или iSCSI. Доступ к одному и тому же тому может быть только через один протокол.

- Allowed Host – список хостов, которым разрешен доступ к тому. По умолчанию разрешено всем (*). Однако рекомендуется всегда явно указывать разрешения для исключения конфликтов доступа и, соответственно, повреждения файловой системы. Для Fibre Channel указываются WWPN хостов (с возможностью выбора из всех доступных в SAN сети). Для iSCSI указываются IQN хостов. В случае нескольких хостов они добавляются по кнопке Add Host. Со стороны Windows значения WWPN и IQN можно узнать через консольную (PowerShell) команду Get-InitiatorPort

![Удаленная установка windows server на новый сервер supermicro [knowledge wikibase]](http://befam.ru/wp-content/uploads/5/1/2/512458631addfba8636c61c8a57d4aef.png)